手册

- Unity 用户手册 2020.3 (LTS)

- New in Unity 2020 LTS

- 包

- 已验证包

- 2D Animation

- 2D Pixel Perfect

- 2D PSD Importer

- 2D SpriteShape

- Adaptive Performance

- Addressables

- Advertisement

- Alembic

- Analytics Library

- Android Logcat

- Animation Rigging

- AR Foundation

- ARCore XR Plugin

- ARKit Face Tracking

- ARKit XR Plugin

- Burst

- Cinemachine

- Code Coverage

- Core RP Library

- Editor Coroutines

- FBX Exporter

- High Definition RP

- In App Purchasing

- Input System

- iOS 14 广告支持

- JetBrains Rider 编辑器

- Magic Leap XR Plugin

- ML Agents

- Mobile Notifications

- Multiplayer HLAPI

- Oculus XR Plugin

- OpenXR 插件

- Polybrush

- Post Processing

- ProBuilder

- Profile Analyzer

- Quick Search

- Recorder

- Remote Config

- Scriptable Build Pipeline

- Shader Graph

- Test Framework

- TextMeshPro

- 时间轴

- Unity Distribution Portal

- Universal RP

- 版本控制

- Visual Effect Graph

- Visual Studio Code 编辑器

- Visual Studio 编辑器

- WebGL Publisher

- Windows XR Plugin

- Xiaomi SDK

- XR Plugin Management

- 预览包

- 核心包

- 内置包

- AI

- Android JNI

- 动画

- Asset Bundle

- Audio

- 布料

- Director

- Image Conversion

- IMGUI

- JSONSerialize

- Particle System

- 物理 (Physics)

- Physics 2D

- Screen Capture

- Terrain

- Terrain Physics

- Tilemap

- UI

- UIElements

- Umbra

- Unity Analytics

- Unity Web Request

- Unity Web Request Asset Bundle

- Unity Web Request Audio

- Unity Web Request Texture

- Unity Web Request WWW

- Vehicles

- Video

- VR

- Wind

- XR

- 按关键字排列的包

- Unity 的 Package Manager

- 创建自定义包

- 已验证包

- 在 Unity 中操作

- 安装 Unity

- 升级 Unity

- Unity 的界面

- 创建游戏玩法

- 编辑器功能

- 分析

- Asset Workflow

- 输入

- 2D

- 图形

- 渲染管线

- 摄像机

- 后期处理

- 光照

- 支持的模型文件格式

- 网格

- 纹理

- 着色器

- Shaders core concepts

- 内置着色器

- 标准着色器

- 标准粒子着色器

- Autodesk Interactive 着色器

- 旧版着色器

- 内置着色器的用途和性能

- 普通着色器系列

- 透明着色器系列

- 透明镂空着色器系列

- 自发光着色器系列

- 反光着色器系列

- 反射顶点光照 (Reflective Vertex-Lit)

- 反光漫射 (Reflective Diffuse)

- 反光镜面反射 (Reflective Specular)

- 反光凹凸漫射 (Reflective Bumped Diffuse)

- 反光凹凸镜面反射 (Reflective Bumped Specular)

- 反光视差漫射 (Reflective Parallax Diffuse)

- 反光视差镜面反射 (Reflective Parallax Specular)

- 反光法线贴图无光照 (Reflective Normal Mapped Unlit)

- 反光法线贴图顶点光照 (Reflective Normal mapped Vertex-lit)

- 使用 Shader Graph

- 编写着色器

- 编写着色器概述

- ShaderLab

- ShaderLab:定义 Shader 对象

- ShaderLab:定义子着色器

- ShaderLab:定义一个通道

- ShaderLab:添加着色器程序

- ShaderLab:命令

- ShaderLab:使用 Category 代码块对命令进行分组

- ShaderLab 命令:AlphaToMask

- ShaderLab 命令:Blend

- ShaderLab 命令:BlendOp

- ShaderLab 命令:ColorMask

- ShaderLab 命令:Conservative

- ShaderLab 命令:Cull

- ShaderLab 命令:Offset

- ShaderLab 命令:模板

- ShaderLab 命令:UsePass

- ShaderLab 命令:GrabPass

- ShaderLab 命令:ZClip

- ShaderLab 命令:ZTest

- ShaderLab 命令:ZWrite

- ShaderLab 旧版功能

- Unity 中的 HLSL

- Unity 中的 GLSL

- Example shaders

- 编写表面着色器

- 为不同的图形 API 编写着色器

- 着色器性能和性能分析

- 材质

- 粒子系统

- 选择粒子系统解决方案

- 内置粒子系统

- 使用内置粒子系统

- 粒子系统顶点流和标准着色器支持

- 粒子系统 GPU 实例化

- 粒子系统 C# 作业系统集成

- 组件和模块

- 粒子系统 (Particle System)

- 粒子系统模块

- 粒子系统 (Particle System) 主模块

- Emission 模块

- Shape 模块

- Velocity over Lifetime 模块

- Noise 模块

- Limit Velocity Over Lifetime 模块

- Inherit Velocity 模块

- Lifetime by Emitter Speed

- Force Over Lifetime 模块

- Color Over Lifetime 模块

- Color By Speed 模块

- Size over Lifetime 模块

- Size by Speed 模块

- Rotation Over Lifetime 模块

- Rotation By Speed 模块

- External Forces 模块

- Collision 模块

- Triggers 模块

- Sub Emitters 模块

- Texture Sheet Animation 模块

- Lights 模块

- Trails 模块

- Custom Data 模块

- Renderer 模块

- 粒子系统力场 (Particle System Force Field)

- 内置粒子系统示例

- Visual Effect Graph

- 创建环境

- 天空

- 视觉效果组件

- 高级渲染功能

- 优化图形性能

- Color

- 物理系统

- 脚本

- 多玩家和联网

- 音频

- 视频概述

- 动画

- 创建用户界面 (UI)

- 导航和寻路

- Unity 服务

- Setting up your project for Unity services

- Unity Organizations

- Unity Ads

- Unity Analytics

- Unity Cloud Build

- Automated Build Generation

- 支持的平台

- 支持的 Unity 版本

- 共享链接

- 版本控制系统

- 使用 Unity 开发者控制面板 (Developer Dashboard) 对 Unity Cloud Build 进行 Git 配置

- 使用 Unity 开发者控制面板 (Developer Dashboard) 对 Unity Cloud Build 进行 Mercurial 配置

- 将 Apache Subversion (SVN) 用于 Unity Cloud Build

- 使用 Unity 开发者控制面板 (Developer Dashboard) 对 Unity Cloud Build 进行 Perforce 配置

- 使用 Unity 开发者控制面板 (Developer Dashboard) 对 Unity Cloud Build 进行 Plastic 配置

- 发布到 iOS

- 高级选项

- 在 Unity Cloud Build 中使用可寻址资源

- 编译清单

- 计划构建

- Cloud Build REST API

- Unity Cloud Content Delivery

- Unity IAP

- Setting up Unity IAP

- 跨平台指南

- 应用商店指南

- 实现应用商店

- Unity Collaborate

- Setting up Unity Collaborate

- Adding team members to your Unity project

- 查看历史记录

- Enabling Cloud Build with Collaborate

- 管理 Unity Editor 版本

- Reverting files

- Resolving file conflicts

- 排除资源使其不发布到 Collaborate

- 将单个文件发布到 Collaborate

- 还原项目至以前的版本

- 进行中 (In-Progress) 编辑通知

- 管理云存储

- 将项目移动到另一个版本控制系统

- Unity Accelerator

- Collaborate troubleshooting tips

- Unity Cloud Diagnostics

- Unity Integrations

- Multiplayer 服务

- Unity 分发平台

- XR

- 开源代码仓库

- Unity Asset Store

- 平台开发

- 将“Unity 用作库”用于其他应用程序

- 启用深层链接

- 独立平台

- macOS

- Apple TV

- WebGL

- iOS

- Android

- Windows

- 将 Unity 集成到 Windows 和 UWP 应用程序中

- Windows 通用

- 通用 Windows 平台

- 已知问题

- 旧版主题

- 术语表

- Unity 用户手册 2020.3 (LTS)

- XR

- 单通道立体渲染(双宽渲染)

- 单通道实例化渲染

单通道实例化渲染

使用__单通道实例化 (Single Pass Instanced)__ 渲染(也称为立体实例化)的情况下,由 GPU 执行单个渲染通道,将每个绘制调用替换为实例化绘制调用。由于两个绘制调用之间的缓存一致性,因此可大大降低 CPU 的使用,并略微减少 GPU 的使用。这样可以大幅降低应用程序的功耗。

支持的平台

- PlayStation VR

- Oculus Rift (DirectX 11)

- HoloLens

- Magic Leap

- 支持 Multiview 扩展的 Android 设备

- 对于桌面平台上的 DirextX,GPU 必须支持 Direct3D 11 和

VPAndRTArrayIndexFromAnyShaderFeedingRasterizer扩展。 - 对于桌面平台上的 OpenGL,GPU 必须支持以下扩展之一:

GL_NV_viewport_array2GL_AMD_vertex_shader_layerGL_ARB_shader_viewport_layer_array

注意:使用延迟渲染时,Unity 不支持旧版渲染管线中的单通道立体实例化。

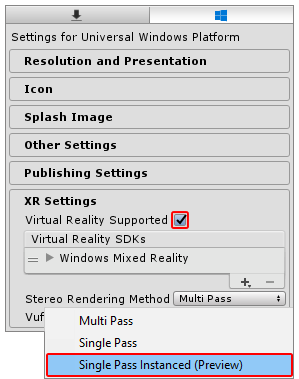

要启用此功能,请打开 Player 设置(选择 Edit > Project Settings__,然后选择 Player__ 类别)。在 Player 设置中,导航到底部的 XR Settings 面板,选中 Virtual Reality Supported 选项,然后从 Stereo Rendering Method 下拉菜单中选择 Single Pass Instanced (Preview)。

默认的 Stereo Rendering Method 为 Multi Pass。此设置较慢,但通常更适合于自定义着色器。如果有自定义着色器,则可能需要更改这些着色器,使之与 Single Pass Instanced 渲染兼容。

自定义着色器

在按照以下说明操作之前,请更新自定义着色器以使用实例化功能(请参阅 GPU 实例化)。

接下来,对于所有自定义着色器,您需要在片元着色器(顶点/外壳/域/几何体)之前使用的最后一个着色器阶段中进行两项额外的更改。

对于要支持单通道实例化的每个自定义着色器,请执行以下步骤:

__步骤 1:__将 UNITY_VERTEX_INPUT_INSTANCE_ID 添加到 appdata struct。

示例:

struct appdata

{

float4 vertex : POSITION;

float2 uv : TEXCOORD0;

UNITY_VERTEX_INPUT_INSTANCE_ID //插入

};

__步骤 2:__将 UNITY_VERTEX_OUTPUT_STEREO 添加到 v2f output struct。

示例:

struct v2f

{

float2 uv : TEXCOORD0;

float4 vertex : SV_POSITION;

UNITY_VERTEX_OUTPUT_STEREO //插入

};

__步骤 3:__在主 vert 方法的开头添加 UNITY_SETUP_INSTANCE_ID() 宏,然后调用 UNITY_INITIALIZE_OUTPUT(v2f, o) 和 UNITY_INITIALIZE_VERTEX_OUTPUT_STEREO()。

UNITY_SETUP_INSTANCE_ID() 根据 GPU 当前渲染的眼睛来计算内置的 unity_StereoEyeIndex 和 unity_InstanceID Unity 着色器变量并设置为正确值。

UNITY_INITIALIZE_VERTEX_OUTPUT_STEREO 根据 unity_StereoEyeIndex 的值告诉 GPU 应该渲染到纹理数组中的哪只眼睛。此宏还从顶点着色器传输 unity_StereoEyeIndex 的值,确保仅当在片元着色器 frag 方法中调用 UNITY_SETUP_STEREO_EYE_INDEX_POST_VERTEX 时才能在片元着色器中访问该值。

UNITY_INITALIZE_OUTPUT(v2f,o) 将所有 v2f 值初始化为 0。

示例:

v2f vert (appdata v)

{

v2f o;

UNITY_SETUP_INSTANCE_ID(v); //插入

UNITY_INITIALIZE_OUTPUT(v2f, o); //插入

UNITY_INITIALIZE_VERTEX_OUTPUT_STEREO(o); //插入

o.vertex = UnityObjectToClipPos(v.vertex);

o.uv = v.uv;

return o;

}

后期处理着色器

如果希望后期处理着色器支持单通道实例化,请按照“自定义着色器”中的步骤以及以下步骤操作。可从 Unity 网站下载所有 Unity 基础着色器脚本。

对于要支持单通道实例化的每个后期处理着色器,请执行以下步骤:

__步骤 1:__在着色器脚本中的 frag 方法之外添加 UNITY_DECLARE_SCREENSPACE_TEXTURE(tex) 宏(请参阅下面的放置位置示例),这样当您使用特定的立体渲染方法时,GPU 会使用适当的纹理采样器。例如,如果使用多通道渲染,则 GPU 会使用 2D 纹理采样器。对于单通道实例化或多视图渲染,纹理采样器为纹理数组。

__步骤 2:__在片元着色器 frag 方法的开头添加 UNITY_SETUP_STEREO_EYE_INDEX_POST_VERTEX(i)(请参阅下面的放置位置示例)。仅当希望使用 unity_StereoEyeIndex 内置着色器变量来找出 GPU 正在渲染到的眼睛时,才需要添加该宏。这在测试后期处理效果时很有用。

__步骤 3:__采样 2D 纹理时使用 UNITY_SAMPLE_SCREENSPACE_TEXTURE() 宏(请参阅下面的放置位置示例)。标准着色器使用基于 2D 纹理的后缓冲区来对纹理进行采样。单通道立体实例化技术不使用此类型的后缓冲区,因此如果没有指定其他的 2D 纹理采样方法,着色器将无法正确渲染。为防止渲染问题,UNITY_SAMPLE_SCREENSPACE_TEXTURE() 宏会检测正在使用的立体渲染路径,然后以正确的方式自动采样纹理。请参阅 Unity 文档关于 HLSLSupport.cginc 的说明,进一步了解用于深度纹理和屏幕空间阴影贴图的类似宏。

示例:

UNITY_DECLARE_SCREENSPACE_TEXTURE(_MainTex); //插入

fixed4 frag (v2f i) : SV_Target

{

UNITY_SETUP_STEREO_EYE_INDEX_POST_VERTEX(i); //插入

fixed4 col = UNITY_SAMPLE_SCREENSPACE_TEXTURE(_MainTex, i.uv); //插入

// 仅插入颜色

col = 1 - col;

return col;

}

完整的示例着色器代码

下面是模板图像效果着色器的一个简单示例,其中应用了所有前面提到的更改来实现单通道实例化支持。着色器代码的添加位置标记了注释 (//Insert)。

struct appdata

{

float4 vertex : POSITION;

float2 uv : TEXCOORD0;

UNITY_VERTEX_INPUT_INSTANCE_ID //插入

};

//v2f 输出结构

struct v2f

{

float2 uv : TEXCOORD0;

float4 vertex : SV_POSITION;

UNITY_VERTEX_OUTPUT_STEREO //插入

};

v2f vert (appdata v)

{

v2f o;

UNITY_SETUP_INSTANCE_ID(v); //插入

UNITY_INITIALIZE_OUTPUT(v2f, o); //插入

UNITY_INITIALIZE_VERTEX_OUTPUT_STEREO(o); //插入

o.vertex = UnityObjectToClipPos(v.vertex);

o.uv = v.uv;

return o;

}

UNITY_DECLARE_SCREENSPACE_TEXTURE(_MainTex); //插入

fixed4 frag (v2f i) : SV_Target

{

UNITY_SETUP_STEREO_EYE_INDEX_POST_VERTEX(i); //插入

fixed4 col = UNITY_SAMPLE_SCREENSPACE_TEXTURE(_MainTex, i.uv); //插入

// 插入颜色

col = 1 - col;

return col;

}

程序化几何体

使用 Graphics.DrawProceduralIndirect() 和 CommandBuffer.DrawProceduralIndirect() 方法在 GPU 上绘制完全程序化的几何体时,必须注意这两个方法都从计算缓冲区接收参数。这意味着在运行时很难增加实例计数。要增加实例计数,必须手动使计算缓冲区中包含的实例计数加倍。

调试着色器

以下着色器代码将游戏对象渲染为绿色(用户左眼)和红色(右眼)。此着色器对于调试立体渲染非常有用,因为它可用于验证所有立体图形是否正常工作。

Shader "XR/StereoEyeIndexColor"

{

Properties

{

_LeftEyeColor("Left Eye Color", COLOR) = (0,1,0,1)

_RightEyeColor("Right Eye Color", COLOR) = (1,0,0,1)

}

SubShader

{

Tags { "RenderType" = "Opaque" }

Pass

{

CGPROGRAM

#pragma vertex vert

#pragma fragment frag

float4 _LeftEyeColor;

float4 _RightEyeColor;

#include "UnityCG.cginc"

struct appdata

{

float4 vertex : POSITION;

UNITY_VERTEX_INPUT_INSTANCE_ID

};

struct v2f

{

float4 vertex : SV_POSITION;

UNITY_VERTEX_INPUT_INSTANCE_ID

UNITY_VERTEX_OUTPUT_STEREO

};

v2f vert (appdata v)

{

v2f o;

UNITY_SETUP_INSTANCE_ID(v);

UNITY_INITIALIZE_OUTPUT(v2f, o);

UNITY_INITIALIZE_VERTEX_OUTPUT_STEREO(o);

o.vertex = UnityObjectToClipPos(v.vertex);

return o;

}

fixed4 frag (v2f i) : SV_Target

{

UNITY_SETUP_STEREO_EYE_INDEX_POST_VERTEX(i);

return lerp(_LeftEyeColor, _RightEyeColor, unity_StereoEyeIndex);

}

ENDCG

}

}

}